Blog

How Knowledge Graphs, Dimensional Models and Data Products come together

In a data-driven organisation data assets should be modelled in a way that allows key business questions to be answered.

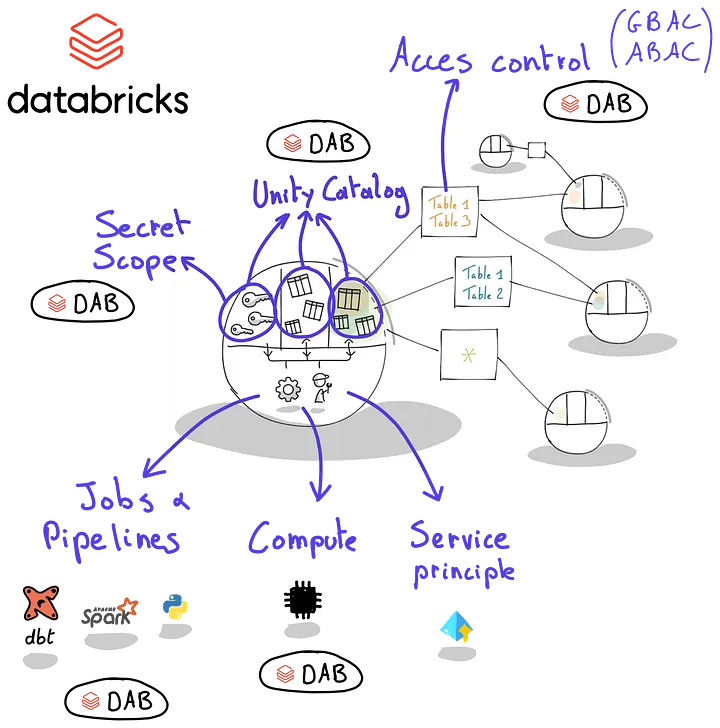

Setting up Databricks for data products

Building secure data products on Databricks is difficult due to its generic nature and the many concepts involved.

From Idea to Implementation: Building an MCP Server for The Data Product Portal

Adding an MCP to enable talking directly to your data using natural language.

Data Product Oriented Architectures

What is the state of the art in data products? Conclusions after the Second Summit on Data Product Oriented Architectures.

The ROI Challenge: Why Measuring Data’s Value is Hard, but Crucial

Too many data products, not enough ROI? Learn how to track value, cost & governance to manage data as a true business asset.

Vermeide schlechte Daten von Anfang an

Das Erfassen aller Daten ohne Qualitätsprüfungen führt zu wiederkehrenden Problemen. Priorisieren Sie die Datenqualität von Anfang an, um nachgelagerte Probleme zu vermeiden.

What Is Data Product Thinking?

Data Product Thinking treats data as a product, empowering domain teams to own, improve, and scale trusted, user-focused data assets.

Datenmodellierung in einer Datenproduktwelt

Viele Organisationen stoßen an die Grenzen der Datenlagerung, insbesondere wenn sie in der Größe wachsen.

Über Medaillon: Wie man Daten für Self-Service-Daten-Teams strukturiert

Seit Jahren verlassen sich Datenplattformen – insbesondere Datenseen und Lakehouses – auf die Medaillonarchitektur.

Das Datenproduktportal integriert sich mit Ihrer bevorzugten Datenplattform.

Vor ein paar Wochen haben wir die Veröffentlichung des Data Product Portals als Open-Source-Repository angekündigt.

Datenprodukt-Portal-Integrationen 2: Helm

Willkommen zur nächsten Folge unserer Serie über die Integrationen des Data Product Portals!

Datenprodukt-Portal-Integrationen 1: OIDC

Wie man Open ID Connect mit dem Data Product Portal integriert

Der Stand der Datenprodukte im Jahr 2024

Gartner hat seinen Hype-Zyklus für Datenmanagement 2024 veröffentlicht.

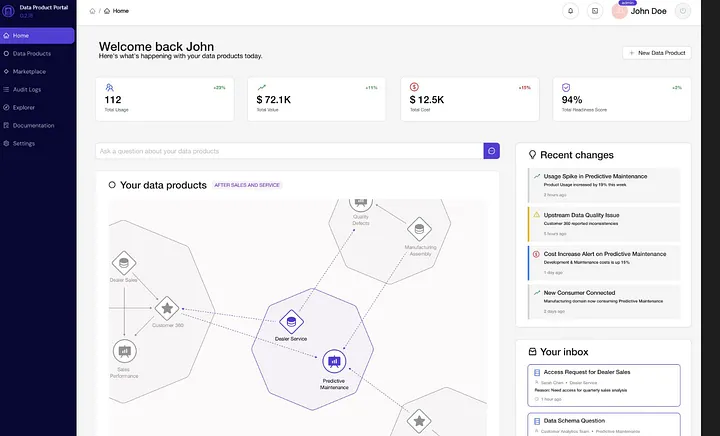

Einführung des Data Product Portal: Ein Open-Source-Tool zur Skalierung Ihrer Datenprodukte

In der sich schnell entwickelnden Welt der Daten stellen Unternehmen fest, dass der Schlüssel zum Erfolg beim Skalieren ihrer Daten

Das fehlende Stück zur Daten-Demokratisierung ist handlungsorientierter als ein Katalog.

Seit den neunziger Jahren, mit dem Aufkommen von Business Intelligence,

Blog

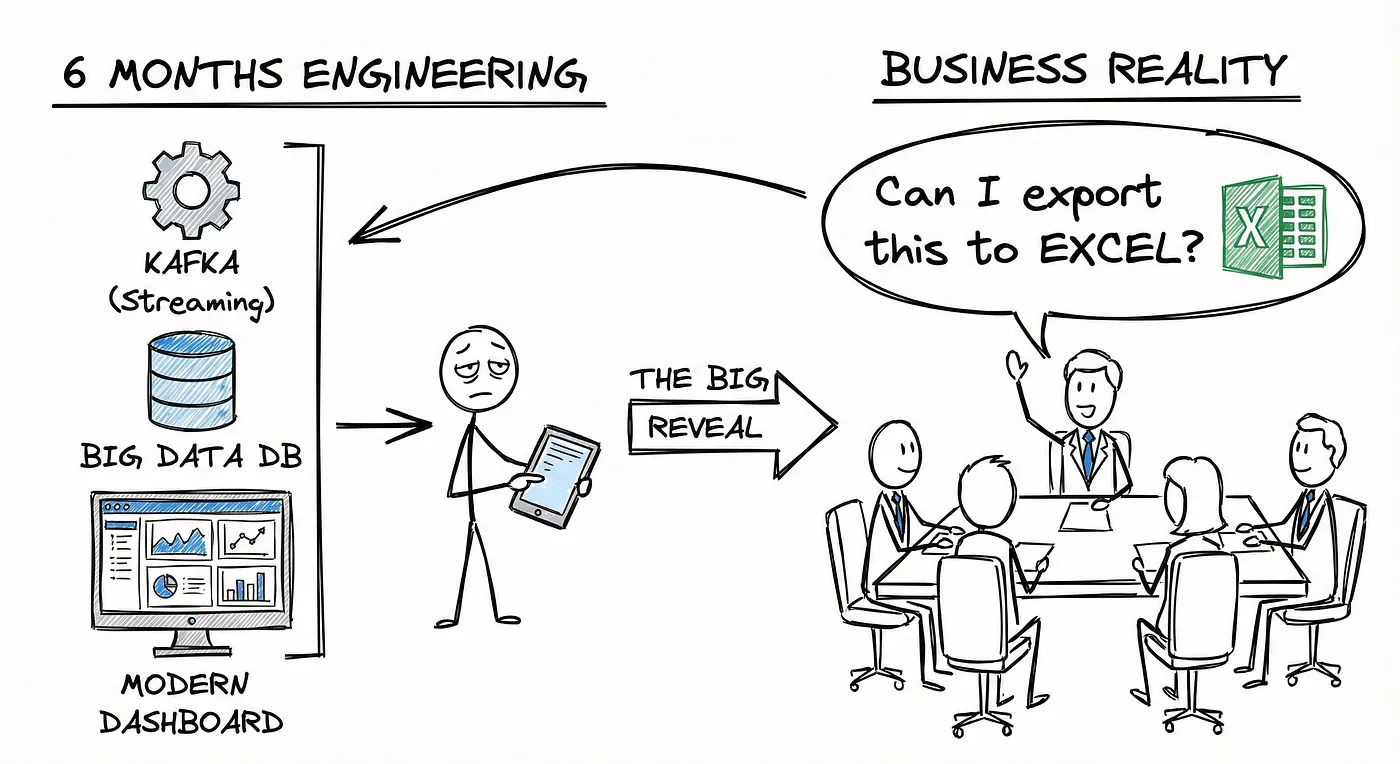

You Don’t Have a Data Platform Without Excel

The Most Used Feature is “Export”: Why Your Data Stack Needs a Spreadsheet Strategy

How to Prevent Crippling Your Infrastructure When AWS US-EAST-1 Fails

Practical lessons on designing for resilience and how to reduce your exposure in case of a major cloud outage.

When writing SQL isn't enough: debugging PostgreSQL in production

SQL alone won’t fix broken data. Debugging pipelines requires context, lineage, and collaborationnot just queries.

Portable by design: Rethinking data platforms in the age of digital sovereignty

Build a portable, EU-compliant data platform and avoid vendor lock-in—discover our cloud-neutral stack in this deep-dive blog.

Ein 5-Schritte-Ansatz zur Verbesserung der Datenplattform-Erfahrung

Verbessern Sie die UX der Datenplattform mit einem 5-Schritte-Prozess: Feedback sammeln, Benutzerreisen kartieren, Reibung reduzieren und kontinuierlich durch Iteration verbessern.

Source-Aligned Data Products: The Foundation of a Scalable Data Mesh

Source-Aligned Data Products ensure trusted, domain-owned data at the source—vital for scalable, governed Data Mesh success.

Wie man die Komplexität des modernen Datenstapels bezwingt

Je mehr Menschen in einem Team sind, desto mehr Kommunikationslinien gibt es. Dasselbe gilt für die Werkzeuge in Ihrem Daten-Stack, die Komplexität skaliert schnell.

Warum Sie eine Benutzeroberfläche für Ihre Datenplattform erstellen sollten

Moderne Datenplattformen sind komplex. Wenn Sie sich Referenzarchitekturen ansehen, wie die von A16Z unten, enthält sie mehr als 30 Kästen.

Die Vorteile eines Data-Platform-Teams

Seit Jahren bauen und nutzen Organisationen Datenplattformen, um Wert aus Daten zu schöpfen.

Warum nicht Ihre eigene Datenplattform erstellen

Eine Zusammenfassung der Diskussion am runden Tisch über die Datenplattform von imec.

Blog

The State of Data Work in 2025: Insights From 32 In-Depth Conversations

Insights from 32 data professionals reveal 2025 challenges: balancing AI innovation, governance, quality, cost, collaboration, and literacy.

Ein Einblick in das Leben eines Datenführers

Datenführer stehen unter Druck, den Hype um KI mit der Organisation der Datenlandschaft in Einklang zu bringen. So bleiben sie fokussiert, pragmatisch und strategisch.

Die Bausteine erfolgreicher Daten-Teams

Basierend auf meiner Erfahrung werde ich die wichtigsten Kriterien für den Aufbau erfolgreicher Daten-Teams näher erläutern.

Wie man ein Datenteam organisiert, um den größten Nutzen aus Daten zu ziehen

Um das Offensichtliche zu sagen: Ein Datenteam ist dafür da, dem Unternehmen Mehrwert zu bieten. Aber ist das wirklich so offensichtlich? Haben Unternehmen nicht zu oft ein ...

Growing your data program with a use-case-driven approach

Use-case-driven data programs balance planning & building, enabling fast value, reduced risk, and scalable transformation.

Blog

Rethinking the data product workbench in the age of AI

Rethinking how AI empowers data teams to build and maintain better data products without replacing them.

Von Gutem AI zu Gutem Data Engineering. Oder wie Verantwortungsbewusste AI mit Hoher Datenqualität zusammenwirkt.

Verantwortliche KI hängt von hochwertiger Datenverarbeitung ab, um ethische, faire und transparente KI-Systeme zu gewährleisten.

Unlocking the new Power of Advanced Analytics

Advanced analytics powered by LLMs and strong data engineering enables smarter predictions, deeper insights, and AI you can trust.

Prompt-Engineering für eine bessere SQL-Codegenerierung mit LLMs

Stellen Sie sich vor, Sie sind ein Marketing-Manager, der damit beauftragt ist, Werbestrategien zu optimieren, um verschiedene Kundensegmente effektiv anzusprechen…

Blog

Using AWS IAM with STS as an Identity Provider

How EKS tokens are created, and how we can use the same technique to use AWS IAM as an identity provider.

Slaying the Terraform Monostate Beast

You start out building your data platform. You choose Terraform because you want to do it the right way and put your infra in code.

When writing SQL isn’t enough: debugging PostgreSQL in production

While writing efficient SQL queries is essential, it is not enough to operate a database at scale.

Authorizing AWS Principals on Azure

How to delegate trust from Entra to AWS IAM through Cognito, authorizing Azure actions without needing long-lived credentials.

Why the ‘Private’ API Gateway of AWS Might Not Be as Secure as You Think

AWS Private API Gateways aren’t always private, misconfigs can expose access. Use resource policies to secure them properly.

Der Leitfaden des Data Engineers zur Optimierung von Kubernetes

Bei Conveyor haben wir über fünf Jahre daran gearbeitet, eine Batch-Datenplattform auf Basis von Kubernetes aufzubauen und zu betreiben.

Integrating MegaLinter to Automate Linting Across Multiple Codebases. A Technical Description.

Automate code quality with MegaLinter, SQLFluff, and custom checks in Azure DevOps CI. Supports multi-language linting and dbt integration.

Sind Ihre AKS-Protokollierungskosten zu hoch? Hier erfahren Sie, wie Sie sie reduzieren können.

Bei Conveyor verwenden wir seit über 3 Jahren Azure Log Analytics, um Protokolle von unseren Kubernetes-Workloads, sowohl von Batch- als auch von langlaufenden Anwendungen, zu speichern.

Monitoring thousands of Spark applications without losing your cool

Monitor Spark apps at scale with CPU efficiency to cut costs. Use Dataflint for insights and track potential monthly savings.

SAP CDC with Azure Data Factory

Build SAP CDC in Azure Data Factory with SAP views, but high IR costs. Kafka + Confluent offers a cheaper, scalable alternative.

How we democratized data access with Streamlit and Microsoft-powered automation

Streamlit app + Power Automate = easy, self-serviced data access at scale, no YAML editing needed, just governance that actually works.

Microsoft Fabric’s Migration Hurdles: My Experience

Migrating to Microsoft Fabric?My experience shows it’s not ideal for modular platforms yet limited flexibility,IaC gaps & performance issues

Datenstabilität mit Python: Wie man selbst die kleinsten Änderungen erfasst

Als Data Engineer ist es fast immer die sicherste Option, Daten-Pipelines alle X Minuten auszuführen. So können Sie nachts gut schlafen…

Entmystifizierung des Geräteflusses

Implementierung des OAuth 2.0 Device Authorization Grant mit AWS Cognito und FastAPI

Alter der DataFrames 2: Polars Ausgabe

In dieser Veröffentlichung präsentiere ich einige Tricks und Funktionen von Polars.

Quack, Quack, Ka-Ching: Kosten senken, indem man Snowflake von DuckDB abfragt

Wie man Snowflakes Unterstützung für interoperable offene Lakehouse-Technologie — Iceberg — nutzen kann, um Geld zu sparen.

Abfragen hierarchischer Daten mit Postgres

Hierarchische Daten sind weit verbreitet und einfach zu speichern, aber ihre Abfrage kann herausfordernd sein. Dieser Beitrag wird Sie durch den Prozess…

Sicher Snowflake von VS Code im Browser verwenden

Eine Hauptaktivität unserer Benutzer besteht darin, dbt innerhalb der IDE-Umgebung zu nutzen.

Zwei Lifecycle-Richtlinien, die jeder S3-Bucket haben sollte

Abgebrochene Mehrteil-Uploads und abgelaufene Löschmarker: was sind sie und warum Sie sich wegen der schlechten AWS-Standarde darum kümmern müssen.

Leveraging Pydantic as a validation layer.

Ensuring clean and reliable input is crucial for building robust services.

Wie wir unsere Docker-Bauzeiten um 40% reduziert haben

Dieser Beitrag beschreibt zwei Möglichkeiten, das Erstellen Ihrer Docker-Images zu beschleunigen: Das Caching von Build-Informationen remote und die Verwendung der Link-Option beim Kopieren von Dateien.

Kreuz-DAG-Abhängigkeiten in Apache Airflow: Ein umfassender Leitfaden

Vier Methoden zur effektiven Verwaltung und Skalierung Ihrer Datenworkflow-Abhängigkeiten mit Apache Airflow erkunden.

Blog

Blog

Beyond the Buzzwords: Let’s Talk About the Real Challenges in Data

Cut through data buzzwords join honest chats with data pros to uncover real challenges, knowledge gaps & clever wins.

Wie man den Druck auf Ihre Daten-Teams verringert

Im August 2016 veröffentlichte BARC die Ergebnisse einer globalen Umfrage zum datengestützten Entscheidungsprozess in Unternehmen.

Klare Signale: Verbesserung der Kommunikation innerhalb eines Datenteams

Clear team communication boosts data project success. Focus on root problems, structured discussions, and effective feedback to align better

Blog

Why Your Next Data Catalog Should Be a Marketplace

Why data catalogs fail - and how a Data Product Marketplace can rebuild trust, drive adoption, and unlock business value from your data.

Locking down your data: fine-grained data access on EU Clouds

Secure Iceberg data on EU clouds with fine-grained access for SQL, Python & Spark using Lakekeeper, Zitadel, and remote signing.