Wie man die Komplexität des modernen Datenstapels bezwingt

29.08.2024

•

Wannes Rosiers

Je mehr Menschen in einem Team sind, desto mehr Kommunikationslinien gibt es. Dasselbe gilt für die Werkzeuge in Ihrem Daten-Stack, die Komplexität skaliert schnell.

Images wie das untenstehende, das aus der Graphentheorie stammt, kommen häufig in (Pseudo-)wissenschaftlichen Forschungen zur idealen Teamgröße vor, da die Anzahl der Kommunikationslinien eine Annäherung an die Komplexität darstellt. Dies hat dazu geführt, dass Software- und Datenteams die Anzahl der Mitglieder in einem (Scrum-)Team begrenzen.

Exponentiell zunehmende Anzahl von Kanten mit zusätzlichen Knoten in einem Graphen

Diese Graphentheorie kann auch in anderen Kontexten verwendet werden. Der moderne Datenstack besteht beispielsweise aus einer Vielzahl von Tools, die alle miteinander integriert werden müssen, was die Komplexität Ihrer Datenlandschaft drastisch erhöht. Vorausgesetzt, Sie können Ihre Datenlandschaft auf ein Tool pro Fähigkeit beschränken, haben Sie immer noch ein Tool für Datenaufnahme, Speicherung, Berechnungen, ETL, Orchestrierung, Visualisierung, fortgeschrittene Analytik und Datenverwaltung: 8 Tools, 28 mögliche Integrationen! Und ich habe noch nicht einmal Monitoring, Sicherheit oder Bereitstellung erwähnt.

Es kann doch nicht so kompliziert sein...

Diese 28 Integrationen klingen beängstigend, oder? Sofort hat man das Gefühl, dass es nicht so kompliziert sein kann, und zum Glück ist es das auch nicht: der Graph ist nicht voll verbunden. Ihr Visualisierungstool beispielsweise muss nicht mit Ihrem Datenerfassungstool integriert sein. Beide "kommunizieren" über Ihre Speicherschicht. Und es gibt viele weitere Integrationen, die Sie weglassen können. Dies lässt Sie jedoch immer noch mit einem erstaunlichen Set von 8 Tools und 17 Integrationen zurück.

8 Tools mit 17 von maximal 28 möglichen Integrationen — Bild von Autor

Einige weit verbreitete Tools auf dem Markt decken mehrere dieser Fähigkeiten ab. dbt ermöglicht es beispielsweise, Berechnungen und Transformationslogik in einem Tool zu haben. Snowflake hingegen bietet Ihnen Speicherung und Berechnung. Und Databricks würde Berechnung und fortgeschrittene Analytik zusammenbringen.

Darüber hinaus kommen die meisten Tools mit einigen Governance-Funktionen daher. Auch wenn Sie damit eine Plattform hätten, bei der das Zugriffsmanagement und andere Governance-Funktionen lokal innerhalb jedes Tools verwaltet werden, ohne einen globalen Überblick, würde dies eine Anzahl von Integrationen eliminieren, da die Datenverwaltungskategorie durch ein Datenkatalog ersetzt werden könnte. Angenommen, Sie beschränken die Governance auf einen Katalog und wählen Snowflake, würde dies weiterhin eine Plattform mit 7 Tools und 11 Integrationen hinterlassen.

7 Tools mit einem Rest von 11 Integrationen zu verwalten — Bild von Autor

Obwohl wir bereits ein Tool aus unserem modernen Datenstack eliminiert haben und die Anzahl der Integrationen drastisch verringert haben, erfordert dieser moderne Datenstack etwas Aufwand.

Es bleibt offensichtlich, dass die Wartung und das Upgrade von 7 Tools und 11 Integrationen eine mühsame und zeitaufwendige Aufgabe ist.

Noch tiefer graben, um mehr Komplexität zu enthüllen

Lasst uns für eine Weile auf die Annäherung der Komplexität Ihrer Datenplattform verzichten, indem wir die Anzahl der Tools und Integrationen messen, und sehen wir es aus einem anderen Blickwinkel, lassen Sie uns zu den Datenabhängigkeiten wechseln. Abgesehen von den Namenskonventionen war ein typischer Ansatz, die Daten so zu speichern, sie zu bereinigen und sie nutzbar zu machen.

Traditioneller Schichtenansatz mit wenigen (2) Datenabhängigkeiten, verwaltet von einem einzelnen Team — Bild von Autor

Es ist auch bemerkenswert, dass traditionell dieses Setup von einem zentralen Daten-Team implementiert und verwaltet wurde. Da wir wieder von Menschen sprechen: Es musste eine Kommunikation vorhanden sein, um zu besprechen, wie die Daten von der Quelle zum Bronze- und dann zum Goldstandard gelangen und wie die Daten strukturiert werden. Infolgedessen musste das zentrale Datenteam Experten in Ihrem gesamten Unternehmen sein. Sagen wir, das ist ziemlich unrealistisch.

Dies hat dazu geführt, dass immer mehr Unternehmen mehrere Teams einführen, die mit Daten innerhalb ihres geschäftlichen Kontextes arbeiten, während sie die Wiederverwendbarkeit ihrer Daten garantieren. Dies wird als Einführung von Produktdenken in Daten oder dem Aufbau von Datenprodukten im Kontext eines Geschäftsfeldes bezeichnet. Als Nachteil führen diese Unternehmen mehr Datenübergaben oder Kommunikationslinien ein.

Ein Nebeneffekt, mehrere Teams mit Daten arbeiten zu lassen, ist, dass sie nicht alle dasselbe technische Fachwissen oder dieselben Werkzeugvorlieben haben. Dies erhöht das Risiko, auf einen Datenstack mit noch mehr Tools und Integrationen zu landen. Aber auch wenn es Ihnen gelingt, Ihre Datenlandschaft schlank zu halten und die Anzahl technischer Integrationen zu minimieren, werden Ihre Kommunikationslinien exponentiell steigen.

Brauchen wir diesen komplexen Datenstack?

Man könnte sich fragen, ob wir diesen komplexen Datenstack brauchen? Angenommen, Sie sind sich bereits sicher, dass Sie einen Datenstack benötigen und dass Sie wertvolle Datenanwendungsfälle haben. Dies sollte wirklich die erste Frage sein, die Sie sich stellen, aber nicht der Fokus dieses Blogbeitrags. Zweitens gibt es zwei Fragen, die beantwortet werden müssen:

Benötige ich separate Tools für jede Fähigkeit?

Benötige ich mehrere Teams, um mit Daten zu arbeiten?

Fangen wir mit der zweiten Frage an, da die Unterfragen, die zu der Antwort führen, klarer sind. Es geht darum, wie weit Sie gehen wollen und müssen, um die Datenbedürfnisse der Leute selbst zu bedienen. Denken Sie daran, dass ein einzelnes, zentrales Datenteam die gesamte Struktur Ihres Unternehmens verstehen muss, bis hin zu den Zielen jeder Abteilung und der technischen Implementierung jedes Geschäftsfeldes. Bei einer bestimmten Anzahl von Geschäftsfeldern müssen Sie den Fokus auf die Datenarbeiter lenken. Wenn Sie den Fokus setzen, indem Sie sie einem einzelnen Geschäftsfeld zuordnen, sollten Sie überlegen, sie nah bei ihren Interessengruppen zu organisieren. Es ist ein natürlicher nächster Schritt nach der Selbstbedienungs-BI, den ich zuvor als die dritte Welle der Daten-Demokratisierung bezeichnet habe.

Föderierte Datenprodukte, die dritte Welle der Daten-Demokratisierung — Bild von Autor aus einem früheren Blog

Von einer gegebenen Skala der Geschäftsfähigkeiten und Datenarbeiter macht es Sinn, zu mehreren Teams überzugehen, aber es liegt an Ihnen zu entscheiden, wo dieser Wendepunkt für Sie liegt. Die resultierende Organisationsstruktur beeinflusst auch die Antwort auf die erste Frage „Benötige ich separate Tools für jede Fähigkeit?“, da mehr Menschen, die in mehreren Teams aufgeteilt sind, die erforderlichen Fähigkeiten beeinflusst und wahrscheinlich bedeutet, dass Sie Personen haben, die mit verschiedenen technischen Niveaus in Ihrem Datenstack arbeiten.

Der Begriff "Moderner Datenstack" gewann etwa 2019–2020 an Bedeutung. Immer mehr Unternehmen schufen eine Datenlandschaft, die aus best-in-class Tools für jede Fähigkeit bestand, und beinhalteten viele Open-Source-Tools und Cloud-Anbieter-Dienste. Selbst große Anbieter wie Snowflake, dbt, Fivetran und andere positionierten sich als Teil des modernen Datenstacks. Heute jedoch fügen diese großen Anbieter ihren Tools mehr Fähigkeiten hinzu: denken Sie an Databricks, das Einheit hinzufügt, Snowflake, das Streamlit kauft, Collibra, das Daten-Shopping und Datenzugriffsmanagement einführt, …

Auch wenn sich der Anbieter-Markt ändert, ziehen viele Organisationen es immer noch vor, Open-Source-Tools und Cloud-Anbieter-Dienste oder eine Kombination aus beiden zu verwenden: Viele Cloud-Anbieter bieten beispielsweise eine verwaltete Airflow an. Auch wenn der Anbieterraum nach Konvergenz sucht, bleibt die Frage gültig, und Ihre Antwort hängt von technischen Fähigkeiten, Ingenieurkultur, Budget und vielen anderen Faktoren ab.

Wie macht man den modernen Datenstack handhabbar?

Angenommen, Sie ziehen es vor, best-in-class Tools zu verwenden, anstatt eine Anwendung zu versuchen, die alles löst. Wie stellen Sie sicher, dass dies handhabbar bleibt? Lassen Sie uns zunächst festhalten, dass der Aufbau einer Datenplattform selten eine Kernkompetenz oder ein zentrales Anliegen einer Organisation ist, die eine einführt. Den Wert aus den darauf aufgebauten Datenprodukten zu liefern, ist es. Dies impliziert, dass Sie nach verwalteten Diensten suchen sollten, wo immer es möglich ist, und berechnen sollten, ob die Kosten des verwalteten Dienstes niedriger sind als die Kosten, ihn selbst zu verwalten. In den meisten Fällen ist dies der Fall.

Darüber hinaus gibt es Tools auf dem Markt, die eine Reihe von best-in-class Tools anbieten oder Ihnen helfen, externe Integrationen zu verwalten. Denken Sie an eine Kombination aus Conveyor und Portal beispielsweise.

Conveyor, eine Entwicklungswerkstatt für Datenprodukte, ermöglicht es Ihnen, sich keine Sorgen über Orchestrierung, Erfassung, Berechnung und das Schreiben von Transformationslogik machen zu müssen, da es mit best-in-class Akteuren in diesen Bereichen ausgestattet ist. Außerdem deckt es Ihre Monitoring-, Sicherheits- und Bereitstellungsfähigkeiten ab, die wir vorerst ausgelassen haben.

Das Datenprodukt-Portal, ein Governance-Tool für Prozesse, stellt die meisten Governance-Funktionen bereit und ermöglicht es Ihnen, sich sicher auf eine zusätzliche Datenverwaltung zu beschränken, während Sie den Überblick behalten. Es vereinfacht auch erheblich die Einarbeitung neuer Datenprodukte und alles, was Sie für deren Erstellung benötigen.

Noch mehr: Sowohl Portal als auch Conveyor vereinfachen die Integrationen mit anderen Tools wie Speicher- und Datenkatalogen. Und als letztes Plus kommt Conveyor als verwalteter Dienst, was wiederum die Wartung, die Sie haben, reduziert. Portal ist derzeit nur als Open-Source-Projekt verfügbar und hat noch kein verwaltetes Angebot.

In der Vergangenheit habe ich persönlich die Einschätzung abgegeben, dass die Wartung aller Tools, die Conveyor anbietet, deren Integration und wiederum die Wartung der Integrationen, ein Vollzeitjob für mindestens 2 unserer 30 Dateningenieure war. Aus einer Kosten-Nutzen-Perspektive können Sie berechnen, was Sie für diese Tools ausgeben können, um profitabel zu sein und Ihren Fokus auf das zu lenken, was wirklich zählt: den Wert darauf aufzubauen.

Vereinfachte Kommunikation und Zusammenarbeit

Noch einmal auf die Teamstrukturen und Kommunikationslinien zurückkommend, ein Setup wie das oben genannte senkt nicht die Anzahl der Kommunikationslinien, sondern vereinfacht sie. Das Datenproduktportal ist der Einstiegspunkt für jede Benutzerreise und damit der einzige Kommunikationsort. Auch wenn es viele Abhängigkeiten und Interaktionen gibt, reduziert ein solcher einzelner Kommunikationskanal die Komplexität erheblich.

Latest

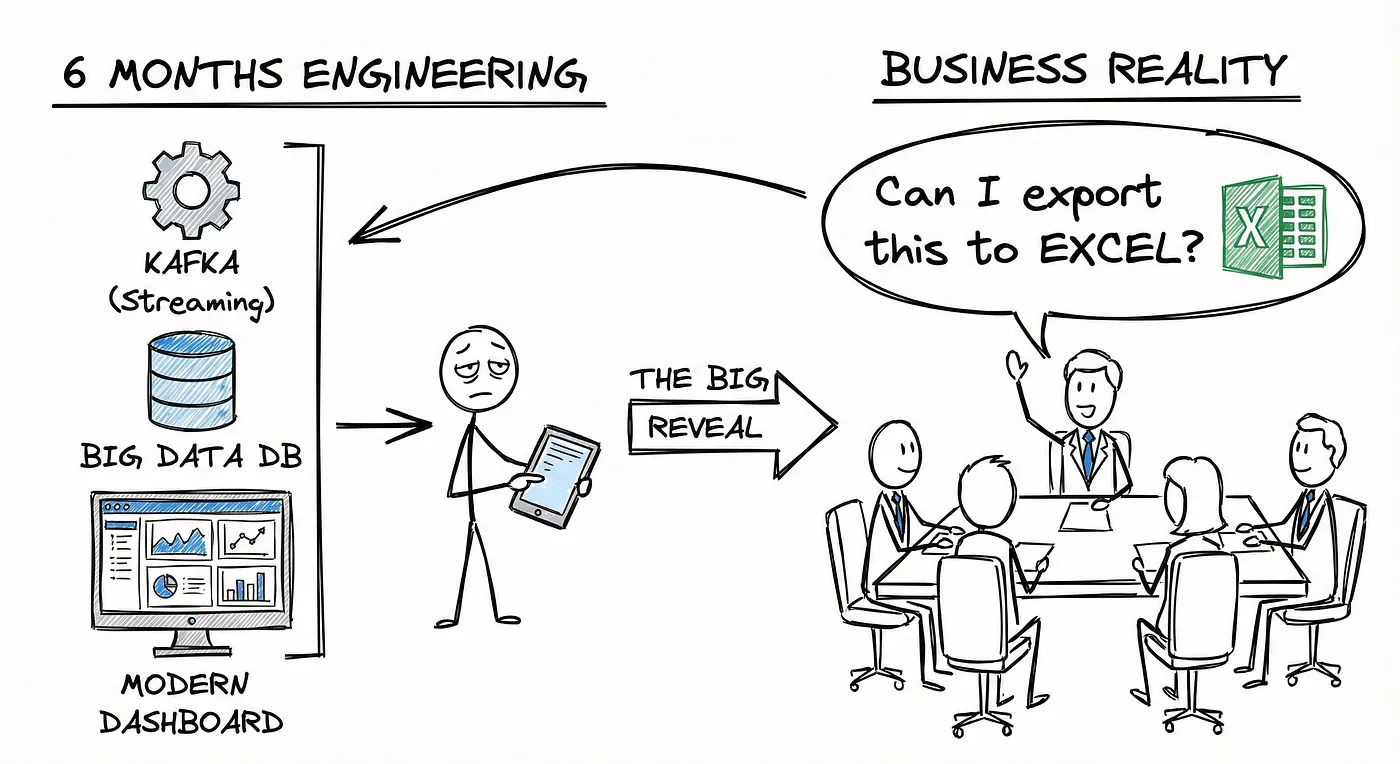

You Don’t Have a Data Platform Without Excel

The Most Used Feature is “Export”: Why Your Data Stack Needs a Spreadsheet Strategy

How Knowledge Graphs, Dimensional Models and Data Products come together

In a data-driven organisation data assets should be modelled in a way that allows key business questions to be answered.

Using AWS IAM with STS as an Identity Provider

How EKS tokens are created, and how we can use the same technique to use AWS IAM as an identity provider.